Сцилла и Харибда искусственного интеллекта

13.01.2013, 19:55

Источник: www.softodrom.ru

Подобно герою «Одиссеи» Гомера, человечество на своем пути движется от одной опасности к другой. Причем ту угрозу, о которой пойдет речь здесь, обойти стороной никак нельзя. Но опасность эта двояка. Так что единственно верный маршрут – умудриться пройти ее посередине.

Речь, конечно же, идет об очень быстро прогрессирующих ныне компьютерных подсистемах, обобщенно именуемых «искусственным интеллектом» или кратко ИИ.

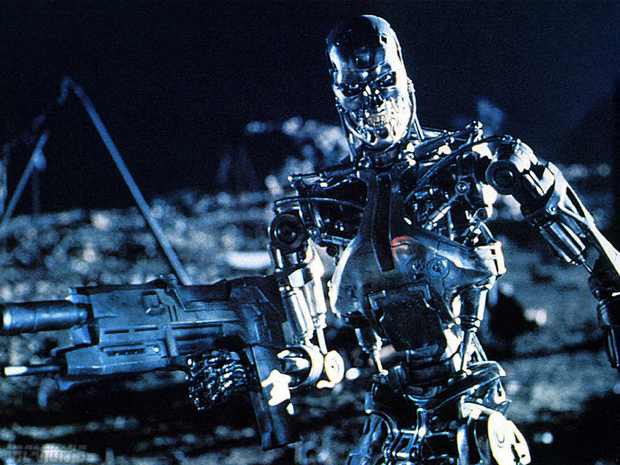

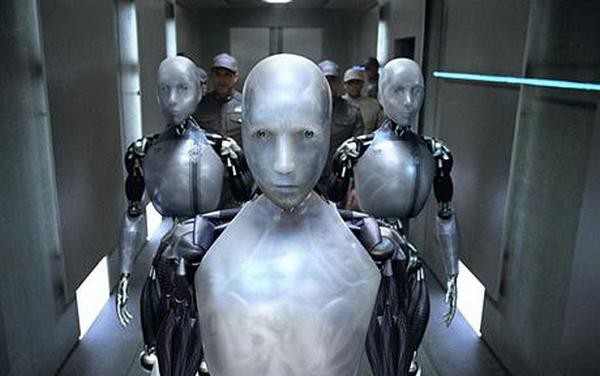

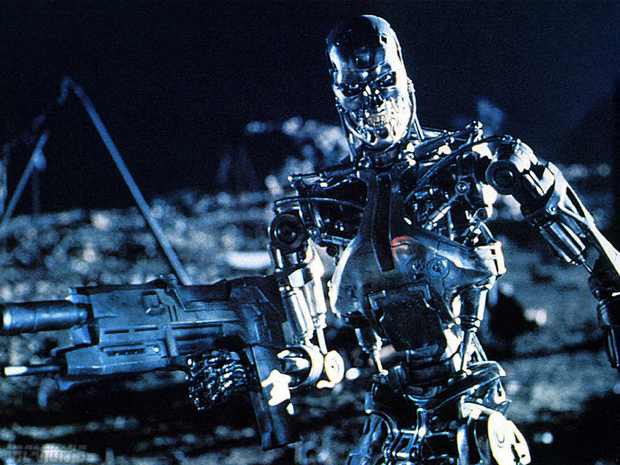

Те две гигантские опасности ИИ, что поджидают нас в недалеком будущем и в потенциале способны привести к исчезновению человека как биологического вида, условно можно называть «угроза Терминатора» и «технологическая сингулярность».

Поскольку остановить прогресс развития роботов и компьютерных систем в целом при любом реалистичном сценарии развития человечества не представляется возможным, обойти эти проблемы стороной нам никак не удастся. Проблема очевидна и ее надо решать.

О том, что делается на данном направлении сегодня, и пойдет речь.

Но начало истории, однако, будет не очень серьезным – дабы не нагнетать...

Хвала господу

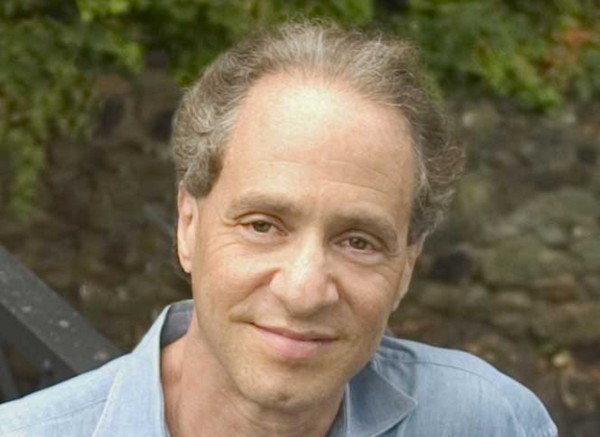

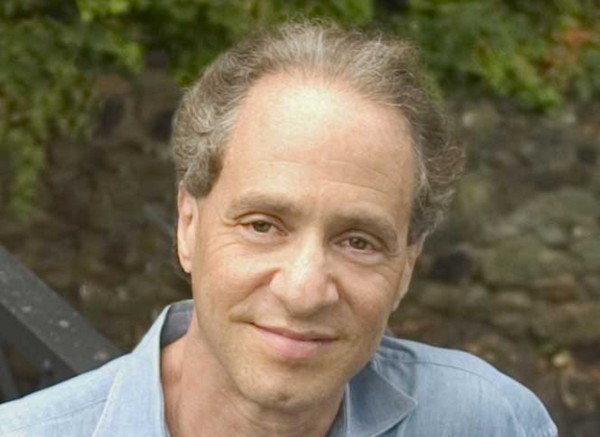

Когда в середине декабря прошла новость, что корпорация Google наняла в качестве директора по инжинирингу известного футуролога и изобретателя Рэя Курцвейла (Ray Kurzweil), наиболее своеобразно отреагировал на это известие научно-популярный журнал MIT Technology Review.

Там появилась небольшая статья примерно такого содержания: «Наняв к себе Курцвейла, Google только что убил Сингулярность. Хвала господу. Теперь у Курцвейла не останется времени на ту чепуху, которой он занимался».

Для начала, автор статьи задается риторическим вопросом – неужели одна из самых головастых в мире компаний неожиданно купилась на идеи Курцвейла о «технологической сингулярности»? И сам же же себе отвечает (в духе товарища Сухова): «Ну, это вряд ли»...

Куда более правильным будет считать, заключает статья, что этим маневром руководители Google только что подписали курцвейловой Сингулярности смертный приговор – поставив ее главного проповедника заниматься тем, что он делает лучше всего: изобретать все лучшие и лучшие машины для реального мира. А не писать свои бредоватые фантастические басни.

Короче говоря, за этот подвиг компанию Google и лично Ларри Пэйджа надо бы наградить, считают в MIT TR, какой-нибудь подходящей медалью. Типа за спасение человечества...

О странноватых и довольно сомнительных, нельзя не признать, идеях футуриста Курцвейла еще понадобится вспомнить ближе к финалу. А пока о вещах более серьезных.

Без команды не стрелять

В последних числах ноября 2012 министерство обороны США решило навестить ясность в вопросах применения своих боевых роботов. Был издан официальный документ, согласно которому всякий раз, когда один из летающих дронов Пентагона открывает смертоносный огонь на поражение цели, то это непременно результат решения, сделанного ответственным человеком. Который, в свою очередь, является лишь звеном в цепи команд и распоряжений, предписанных законом для подобного рода операций...

Иначе говоря, военное министерство сочло необходимым прореагировать на уже регулярно возникающие запросы и протесты общественности. Ибо масштабы боевого применения дронов неуклонно нарастают, а группы правозащитников и прочие обеспокоенные граждане всерьез опасаются, что технологический прогресс в этой области постепенно ведет к тому дню, когда автономные роботы начнут сами делать критически важные решения.

Однако согласно новой политической директиве, принятой ныне руководством Пентагона, никакого «восстания машин» не должно происходить в принципе.

Заместитель министра обороны Эштон Картер (Ashton Carter) подписал 21 ноября с.г. набор инструкций, требующих, чтобы на всех этапах, начиная со стадии разработки, была «минимизирована вероятность и последствия сбоев» в автономных и полуавтономных вооруженных роботах, способных «приводить к непреднамеренному боевому столкновению».

В переводе с бюрократического новояза, суть этого достаточно многословного документа сводится к тому, что Пентагон дает обществу своего рода гарантии. И официально заверяет, что нет ни одного обстоятельства, при котором какой-либо из множества военных дронов типа Predator, Reaper, роботоподобных ракетных снарядов или всех прочих смертоносных роботов мог бы эффективно автоматизировать процесс принятия решения о нанесении вреда человеческому существу.

В частности, аппаратное и программное обеспечение, управляющее боевыми роботами, должно поступать на вооружение уже оборудованным «средствами безопасности, механизмами блокирования проникновений и гарантированной защиты информации». А конструкция в целом должна иметь надлежащие «средства управления и интерфейсы человек-машина».

Самое же главное, роботы должны функционировать строго «в соответствии с намерениями командира и оператора, а если не могут этого сделать, то должны прерывать боевые действия и заняться поиском дополнительных команд от оператора, прежде чем продолжать сражение».

Если же таких механизмов у робота не будет, то Пентагон не намерен ни покупать, ни использовать подобную технику...

Особо следует отметить, что директива Картера, достаточно строгая к боевым дронам, одновременно благословляет, по сути, ускоренный марш вперед в области автономности для всех прочих областей военных роботов, которые не предназначены непосредственно для убийства людей.

Документ оговаривает, что его требования «не применимы к автономным и полуавтономным программным системам для операций в киберпространстве; к невооруженным и не управляемым человеком платформам; к неуправляемым боеприпасам; к боеприпасам, управляемым оператором вручную (например, оружие, управляемое с помощью лазерных систем наведения или по проводам); к минам или к невзорвавшимся взрывчатым веществам».

Из этих оговорок становится ясно, что пока Пентагон совершенно не намерен выстраивать аналогичные барьеры предосторожности для тех случаев, когда разрабатываются, скажем, компьютерные черви, которых запускают в сети для выведения из строя промышленных предприятий.

Аналогично, абсолютно никаких ограничений не предусматривается ни для шпионских дронов видовой разведки, ни для автономных программ по сбору информации в компьютерах и интернете.

Если же смотреть в будущее с упреждением не на один, а хотя бы на два шага вперед, то несложно сообразить, что и в других областях автономной работы программ – от промышленных диверсий до тотального сбора информации машинами – таятся немалые угрозы для человека.

Центр против Терминатора

Одна из недавних аналитических статей, посвященных все более четко обозначающейся опасности, носит красноречивое название: «Искусственный интеллект – сможем ли мы его удержать?» (Artificial intelligence – can we keep it in the box?, by Huw Price and Jaan Tallinn).

В этой статье ее авторы, известный кембриджский философ Хью Прайс и один из создателей системы Skype Яаан Таллинн, задаются, таким, в частности, вопросом.

Мы знаем, как иметь дело со всякими подозрительными пакетами и сумками – осторожно, насколько это только возможно! Ныне мы даже располагаем специальными роботами, которые берут на себя риски подобного рода. Но имеет смысл задуматься: а что если роботы – это и есть главный риск?

На сегодняшний день уже в достатке хватает людей, которые доказывают, что нам следовало бы обходиться с искусственным интеллектом точно таким же образом, как с бесхозными подозрительными сумками. Потому что однажды и системы ИИ могут точно так же взорваться прямо нам в лицо.

Довольно давно, когда американского математика и фантаста Вернора Винджа как-то раз спросили, наступит ли время, когда компьютеры станут такими же умными как люди, он ответил: «Да, но только длиться это будет совсем недолго»

Иначе говоря, как только компьютеры достигнут такого же уровня интеллекта, как у нас, не останется уже ничего, что помешало бы им двинуться намного дальше, причем с очень большой скоростью. Именно Виндж окрестил этот неожиданный взрыв разумности машин «технологической сингулярностью». И по его мнению, это событие вряд ли окажется доброй вестью – с точки зрения человечества...

Тут пора отвлечься от цитирования умных людей и вернуться к дням сегодняшним.

Точно неизвестно, случайное это совпадение событий или же своего рода «знак времени», но примерно в тех же числах ноября произошло еще вот что. Когда Пентагон пообещал строго следить за своими боевыми роботами, в британском университете Кембридж объявили о создании специального научно-исследовательского центра для систематического «изучения опасностей Терминатора».

Такое название, конечно же, употребляют лишь в неофициальных пояснениях для прессы, а формально новая структура получила название CSER или Centre for the Study of Existential Risks – Центр по изучению экзистенциальных рисков.

Вообще говоря, в CSER планируется изучать не только угрозы, которые представляют для человечества роботы и системы искусственного интеллекта в целом, но также прочие смертельного характера опасности, порождаемые руками человека. Вроде техногенных изменений климата, вышедших из под контроля био- и нанотехнологий, или же последствий ядерной войны.

Новый Центр мыслится как структура, которая объединит для междисциплинарного охвата проблем ученых самых разных направлений, включая философию, физику, биологию, роботехнику, нейропсихологию и экономику.

Ну а поскольку тремя отцами-основателями CSER стали уже упомянутые выше Прайс и Таллинн, а также придающий проекту особую солидность лорд Мартин Рис (известный астроном, космолог и глава национальной академии наук в недавнем прошлом), особый упор наверняка будет делаться на угрозы со стороны ИИ.

Чтобы стало яснее, в каком общем ключе мыслятся сейчас будущие исследования, можно привести еще несколько цитат из совместной работы Прайса и Таллинна.

Есть немало авторитетных людей, не желающих видеть тут угрозу. И указывающих на известные факты, согласно которым машины никогда не смогут достичь человеческого уровня разумности. Не говоря уже о том, чтобы его превзойти.

Однако другие не менее умные люди тут же напоминают, что похожие вещи когда-то говорились и о невозможности машин, которые могли бы летать при весе тяжелее воздуха. Более того, история свидетельствует, что даже тогда, когда братья Райт начали поднимать в воздух свои аэропланы, все еще находились люди, отказывавшиеся в это верить.

После сопоставления данных примеров можно также напомнить, что природой давным-давно решены обе эти технические задачи. Летать способны даже весьма тяжелые птицы, а мощь человеческого разума умещается в небольшой объем коробки размером с наш череп...

Более того, разум в нашей голове постоянно продвигается все дальше и дальше в постижении того, каким образом эти вещи удалось сделать природе. И было бы недальновидно полагать, что разгадав одну загадку, мы никогда не сможем постичь вторую.

Сегодня мы уже имеем машины, которые превосходят человека в шахматах, в вождении самолета, автомобиля, в финансовом трейдинге, в распознавании лиц, речи и рукописного текста. И этот перечень все время удлиняется...

Если одна кривая неуклонно нарастает, а другая линия все время остается по сути горизонтальной, то им наверняка предначертано где-то пересечься.

В общих чертах уже даже ясно, когда примерно это должно произойти. Тот момент, когда компьютеры станут писать программы лучше, чем люди, станет и моментом истории, когда скорость технологического прогресса сместится от скорости человеческой мысли и человеческих коммуникаций к скорости работы кремниевых чипов.

Это приближающееся событие можно считать одной из версией того, что Виндж назвал «технологической сингулярностью». После данной точки кривая развития будет направляться уже совершенно новой динамикой. А будущее становится для нас радикально непредсказуемым. Что и подразумевал Виндж в своем прогнозе.

Можно, конечно, благодушно полагать, что всякий разум, который превзойдет нас в своих возможностях, будет примерно такой же как наш – просто будет соображать пошустрее.

Но есть тут очень существенный момент. Практически все, что мы ценим как люди (любовь, счастье, даже личное выживание), имеет для нас такую важность из-за вполне конкретной эволюционная история. Это история, которую мы разделяем с прочими высшими животными. Но не с компьютерными программами вроде искусственного интеллекта.

То есть нет никаких причин считать, будто разумные машины станут разделять наши ценности. Нет, впрочем, и причин считать, что они будут к нам враждебны. Враждебность, по природе своей, тоже эмоция животного.

Но с очень большой вероятностью машины могут оказаться абсолютно к нам безразличны. Мы вполне можем представляться для них примерно тем же, чем для нас являются мошки на ветровом стекле мчащейся машины.

Можно привести и более человекоподобную аналогию. Достаточно посмотреть на горилл, которым поневоле приходится состязаться за ресурсы с наиболее разумными существами на этой планете. Причина, по которой гориллы как вид неуклонно вымирают, отнюдь не в том, что люди в целом к ним враждебны. Но потому, что человек контролирует окружающую среду таким образом, что она становится все более и более непригодна для выживания горилл...

Певец Сингулярности

Примеров и доводов, вероятно, уже достаточно, чтобы всерьез задуматься – как же человеку обеспечить себе будущее рядом с превосходящим его искусственным разумом или «ИИ+».

Один из вариантов предлагает футуролог Рэй Курцвейл – умнейший и талантливый человек. Некоторые называют его просто гениальным изобретателем. Бесспорный вклад Курцвейла в системы машинного обучения (включая оптическое распознавание текста, распознавание и синтез речи) в буквальном смысле уже преобразовал мир, в котором мы живем.

Но как мыслитель и визионер Курцвейл пропагандирует крайне странные вещи. Так, он очень вдохновенно развивает свои богатые технофантазии относительно грядущего человеческого бессмертия – через полное слияние искусственного интеллекта с человеческим сознанием, благодаря тотальному преобразованию нашего организма в тело киборга.

Идеи Курцвейла о необходимости превращения людей в роботов звучат настолько отталкивающе, что Дуглас Хофштадтер, другой известный ученый и мыслитель, однажды назвал эти теории «собачьими какашками, замешанными в хорошую и вкусную еду».

Будущее человечества, по прогнозу Курцвейла, будет выглядеть следующим образом.

К 2020 году персональные компьютеры достигнут вычислительной мощности человеческого мозга. Тогда же, в 2020-х годы, наномашины начнут использовать в медицинских целях, запуская их в человеческий организм.

К 2029 году компьютер сможет пройти тест Тьюринга, доказав наличие у него разума в человеческом понимании слова. В 2030-е годы наномашины будут вставляться уже прямо в мозг и осуществлять произвольный ввод и вывод сигналов из клеток мозга.

В 2040-е годы человеческое тело сможет принимать любую форму, образуемую большим числом нанороботов. Внутренние человеческие органы заменят кибернетические устройства намного лучшего качества.

К 2045 году, по оценкам Курцвейла, наступит технологическая сингулярность. Вот только людей уже практически не будет. Потому что вся Земля начнет превращаться в один гигантский компьютер. Ну а дальше этот процесс понемногу распространится на всю Вселенную...

Открытый финал

Видный австралийский философ Дэвид Чалмерс в недавней исследовательской статье «Сингулярность: философский анализ» делает такое заключение:

Наступит ли сингулярность? Я полагаю, что вопрос этот определенно нельзя сбрасывать со счетов. Но главными обстоятельствами на пути к сингулярности скорее все же будут обстоятельства нашей мотивации, а не обстоятельства наших возможностей.

Так как же нам подходить к проблеме сингулярности? Очень и очень тщательно. Осторожно встраивая соответствующие возможности в машины. И создавая первые мощные системы ИИ и ИИ+ для начала только в условиях виртуального мира, отсоединенного от мира реального.

|

Ключевые слова: Курцвейла машины люди человечество искусственный интеллект интеллект Пентагон человек роботы Google компьютеры дроны сингулярность Искусственный интеллект робот

|